Was ist Automatic Speech Recognition (ASR)?

Automatic Speech Recognition ist ein Verfahren zur automatischen Umwandlung von Sprache in Text. ASR-Technologien nutzen Verfahren des maschinellen Lernens, um Sprachmuster zu analysieren, zu verarbeiten und als Text auszugeben. Automatic Speech Recognition bietet sich für eine Vielzahl von Anwendungen an, die von virtuellen Sprachassistenten über die Erzeugung von Untertiteln für Videos bis hin zur Transkription wichtiger Meetings reichen.

Was bedeutet Automatic Speech Recognition?

Automatic Speech Recognition (ASR), im Deutschen „Automatische Spracherkennung“, stellt ein Teilgebiet der Informatik und Computerlinguistik dar. In diesem geht es darum, Methoden zu entwickeln, die gesprochene Sprache automatisch in eine maschinenlesbare Form übersetzen. Erfolgt die Umwandlung in Text, ist auch von Speech-to-Text (STT) die Rede. ASR-Verfahren basieren auf statistischen Modellen und komplexen Algorithmen.

Mit welcher Präzision ein ASR-System arbeitet, zeigt die sogenannte Wortfehlerrate (WER) auf. Diese setzt die Fehler – also die Anzahl ausgelassener, hinzugefügter und falsch erkannter Wörter – ins Verhältnis zur Gesamtzahl der gesprochenen Wörter. Je niedriger der Wert ausfällt, desto höher ist die Präzision der automatischen Spracherkennung. Liegt die Wortfehlerrate zum Beispiel bei 10 Prozent, weist das Transkript eine Genauigkeit von 90 Prozent auf.

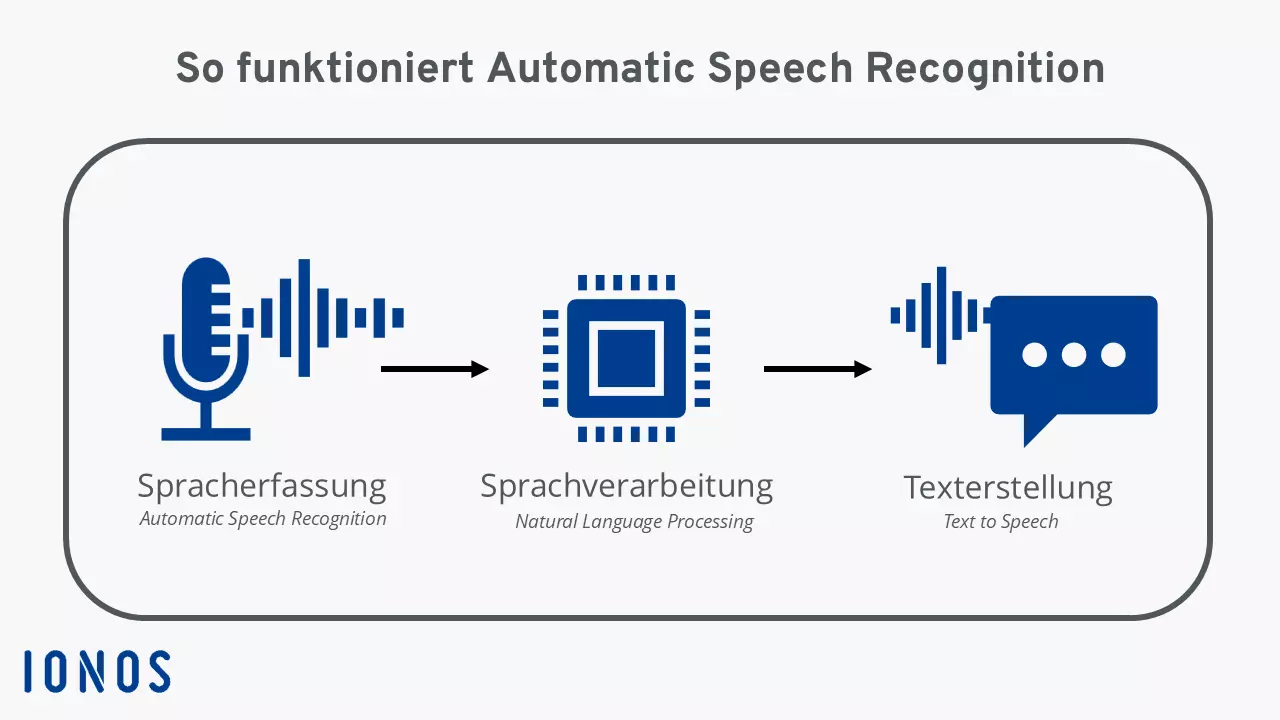

Wie funktioniert Automatic Speech Recognition?

Automatic Speech Recognition setzt sich aus mehreren aufeinanderfolgenden Schritten zusammen, die nahtlos ineinandergreifen. Im Folgenden erläutern wir die einzelnen Phasen näher:

- Spracherfassung (Automatic Speech Recognition): Das System erfasst gesprochene Sprache über ein Mikrofon oder eine andere Audioquelle.

- Sprachverarbeitung (Natural Language Processing): Zunächst wird die Sprachaufnahme von Störgeräuschen bereinigt. Danach analysiert ein Algorithmus die phonetischen und phonemischen Eigenschaften der Sprache. Im Anschluss werden die erfassten Merkmale mit vorher trainierten Modellen verglichen, um einzelne Worte zu identifizieren.

- Textgenerierung (Speech to Text): In einem letzten Schritt wandelt das System die erkannten Laute in Textform um.

ASR-Algorithmen: Hybrider Ansatz vs. Deep Learning

Man unterscheidet grundsätzlich zwei Hauptansätze für Automatic Speech Recognition: Während in der Vergangenheit vor allem klassische hybride Ansätze wie die stochastischen Hidden-Markov-Modelle Verwendung fanden, wird mittlerweile immer häufiger auf Deep-Learning-Technologien zurückgegriffen. Dieser Umstand geht darauf zurück, dass die Präzision traditioneller Modelle in letzter Zeit stagnierte.

Klassischer hybrider Ansatz

Klassische Modelle erfordern zwangsausgerichtete Daten. Das bedeutet, sie nutzen die Texttranskription eines Audio-Sprachsegments, um zu bestimmen, an welcher Stelle bestimmte Wörter auftreten. Der traditionelle hybride Ansatz kombiniert stets ein Lexikonmodell, ein akustisches Modell und ein Sprachmodell, um Sprache zu transkribieren:

- Das Lexikonmodell definiert die phonetische Aussprache der Wörter. Es ist erforderlich, für jede Sprache einen eigenen Daten- beziehungsweise Phonemsatz zu erstellen.

- Das akustische Modell zielt auf die Modellierung akustischer Muster der Sprache ab. Mithilfe der zwangsausgerichteten Daten erstellt es Prognosen, welcher Laut beziehungsweise welches Phonem sich den unterschiedlichen Sprachsegmenten zuordnen lässt.

- Das Sprachmodell lernt, welche Wortfolgen in einer Sprache am wahrscheinlichsten auftreten. Seine Aufgabe besteht darin, vorherzusagen, welche Wörter mit welcher Wahrscheinlichkeit auf die aktuellen Wörter folgen werden.

Der wesentliche Nachteil des hybriden Ansatzes ist, dass es sich schwierig gestaltet, die Genauigkeit der Spracherkennung mithilfe dieser Methode zu erhöhen. Darüber hinaus besteht die Notwendigkeit, drei separate Modelle zu trainieren, was sich als sehr zeit- und kostenintensiv erweist. Da bereits umfangreiches Wissen darüber existiert, wie sich mithilfe des klassischen Ansatzes ein robustes Modell erstellen lässt, entscheiden sich viele Unternehmen dennoch für diese Option.

- 100 % DSGVO-konform und sicher in Deutschland gehostet

- Die leistungsstärksten KI-Modelle auf einer Plattform

- Kein Vendor Lock-in durch Open Source

Deep Learning mit End-to-End-Prozessen

End-to-End-Systeme besitzen die Fähigkeit, eine Folge akustischer Eingangsmerkmale direkt zu transkribieren. Wie die gesprochenen Wörter umzuwandeln sind, erlernt der Algorithmus hier mithilfe einer großen Menge an Datenpaaren in Form von Audiodateien eines konkreten Satzes und der korrekten Transkription.

Deep-Learning-Architekturen wie CTC, LAS und RNNT lassen sich so trainieren, dass sie auch ohne zwangsausgerichtete Daten, Lexikonmodell und Sprachmodell präzise Ergebnisse liefern. Viele Systeme für Deep Learning werden dennoch mit einem Sprachmodell verknüpft, da ein solches dazu beitragen kann, die Genauigkeit der Transkription weiter zu steigern.

In unserem Artikel „Deep Learning vs. Machine Learning“ erfahren Sie, worin sich die beiden Konzepte voneinander unterscheiden.

Der End-to-End-Ansatz für Automatic Speech Recognition punktet nicht nur mit einer höheren Präzision als herkömmliche Modelle. Von Vorteil ist außerdem, dass sich entsprechende ASR-Systeme leichter trainieren lassen und dass sie weniger menschliche Arbeitskraft erfordern.

Automatic Speech Recognition: Was sind die zentralen Anwendungsfelder?

Vor allem dank der Fortschritte im Bereich Machine Learning werden ASR-Technologien immer genauer und leistungsfähiger. Automatic Speech Recognition lässt sich in vielen Branchen verwenden, um Effizienzsteigerungen zu realisieren, die Kundenzufriedenheit zu erhöhen und/oder die Kapitalrendite (ROI) zu verbessern. Zu den wichtigsten Einsatzgebieten zählen:

- Telekommunikation: Kontaktcenter nutzen ASR-Technologien, um Gespräche mit Kundinnen und Kunden zu transkribieren und im Anschluss zu analysieren. Für die Anrufverfolgung und für mittels Cloud-Server realisierte Telefonlösungen werden ebenfalls exakte Transkriptionen benötigt.

- Videoplattformen: Mittlerweile gilt die Erstellung von Untertiteln in Echtzeit auf Videoplattformen als Industriestandard. Automatic Speech Recognition erweist sich außerdem als hilfreich für die Kategorisierung von Inhalten.

- Medienbeobachtung: ASR-APIs gestatten es, TV-Sendungen, Podcasts, Radiosendungen und anderen Medien dahingehend zu analysieren, wie oft bestimmte Marken- oder Themenerwähnungen vorkommen.

- Videokonferenzen: Meeting-Lösungen wie Zoom, Microsoft Teams oder Google Meet sind auf exakte Transkriptionen und die Analyse dieser Inhalte angewiesen, um Schlüsselerkenntnisse zu gewinnen und passende Maßnahmen abzuleiten. Automatic Speech Recognition lässt sich ebenso nutzen, um für Videokonferenzen Live-Untertitel bereitzustellen.

- Sprachassistenten: Ob Amazon Alexa, Google Assistant oder Siri von Apple – virtuelle Sprachassistenten basieren auf Automatic Speech Recognition. Die Technologie gestattet es den Assistenten, Fragen zu beantworten, Aufgaben auszuführen und mit anderen Geräten zu interagieren.

Welche Rolle spielt künstliche Intelligenz bei ASR-Technologien?

Künstliche Intelligenz trägt dazu bei, die Genauigkeit und die allgemeine Funktionalität von ASR-Systemen zu verbessern. Insbesondere die Entwicklung großer Sprachmodelle hat dazu geführt, dass sich natürliche Sprache heutzutage deutlich besser verarbeiten lässt. Ein Large Language Model ist nicht nur in der Lage, komplexe Texte mit hoher Relevanz zu erstellen und Übersetzungen anzufertigen, sondern es erkennt auch die gesprochene Sprache. Daher profitieren ASR-Systeme erheblich von Entwicklungen in diesem Bereich. Darüber hinaus erweist sich künstliche Intelligenz auch bei der Entwicklung akzentspezifischer Sprachmodelle als hilfreich.

- In Sekunden zur Online-Präsenz

- Mehr Wachstum mit KI-Marketing

- Zeit und Ressourcen sparen

Welche Stärken und Schwächen hat Automatic Speech Recognition?

Verglichen mit der traditionellen Transkription bietet Automatic Speech Recognition einige Vorteile. Eine wesentliche Stärke moderner ASR-Verfahren besteht in ihrer hohen Präzision, die darauf zurückgeht, dass sich entsprechende Systeme mit großen Datenmengen trainieren lassen. Das ermöglicht es, die Qualität von Untertiteln beziehungsweise Transkriptionen zu erhöhen und diese zusätzlich in Echtzeit bereitzustellen.

Ein weiterer wichtiger Vorzug ist die Steigerung der Effizienz. Automatic Speech Recognition gestattet es Unternehmen, Skalierungen vorzunehmen, die eigene Palette an Dienstleistungen schneller zu erweitern und diese einem größeren Kundenkreis zu offerieren. Studierenden und Berufstätigen erleichtern Tools mit automatischer Spracherkennung die Dokumentation von Audioinhalten – etwa eines Business-Meetings oder einer Univorlesung.

Von Nachteil ist dagegen, dass ASR-Systeme zwar genauer arbeiten als jemals zuvor, aber immer noch nicht an die Genauigkeit von Menschen heranreichen. Dies geht vor allem auf die vielen Nuancen beim Sprechen zurück. Als Herausforderung erweisen sich insbesondere Akzente, Dialekte und die unterschiedlichen Tonlagen, aber auch Störgeräusche. Selbst die leistungsfähigsten Deep-Learning-Modelle können nicht alle Sonderfälle abdecken. Was ebenfalls als problematisch gilt: ASR-Technologien verarbeiten mitunter personenbezogene Daten, was Bedenken hinsichtlich der Privatsphäre und Datensicherheit aufwirft.