Was ist Random Forest?

Random Forest ist ein Machine-Learning-Algorithmus, der auf einer großen Anzahl von Entscheidungsbäumen basiert. Er gehört zu den zuverlässigsten Methoden für Klassifikation und Regression. Besonders für Anfängerinnen und Anfänger bietet er eine Möglichkeit, erste erfolgreiche Modelle zu entwickeln.

Was ist Random Forest?

Random Forest ist ein Machine-Learning-Algorithmus, bei dem viele einzelne Entscheidungsbäume gemeinsam ein Ergebnis liefern. Statt sich auf einen einzigen Baum zu verlassen, kombiniert das Verfahren die Vorhersagen vieler Modelle, um eine bessere Genauigkeit zu erzielen. Jeder einzelne Baum wird dabei mit leicht unterschiedlichen Daten oder Merkmalen trainiert, was die Vielfalt erhöht. Die Grundidee besteht darin, dass viele einzelne Entscheidungsbäume, die jeweils für sich genommen stark variieren können, gemeinsam ein stabiles Gesamtmodell bilden. Der Random Decision Forest ist weniger anfällig für Overfitting (Überanpassung), da die Vielfalt im Modell die Fehler einzelner Bäume ausgleicht. Der Algorithmus kann sowohl für Klassifikationsaufgaben als auch für Regressionsaufgaben eingesetzt werden. Er arbeitet zuverlässig, selbst wenn die Daten viele Merkmale oder unvollständige Informationen enthalten.

- In Sekunden zur Online-Präsenz

- Mehr Wachstum mit KI-Marketing

- Zeit und Ressourcen sparen

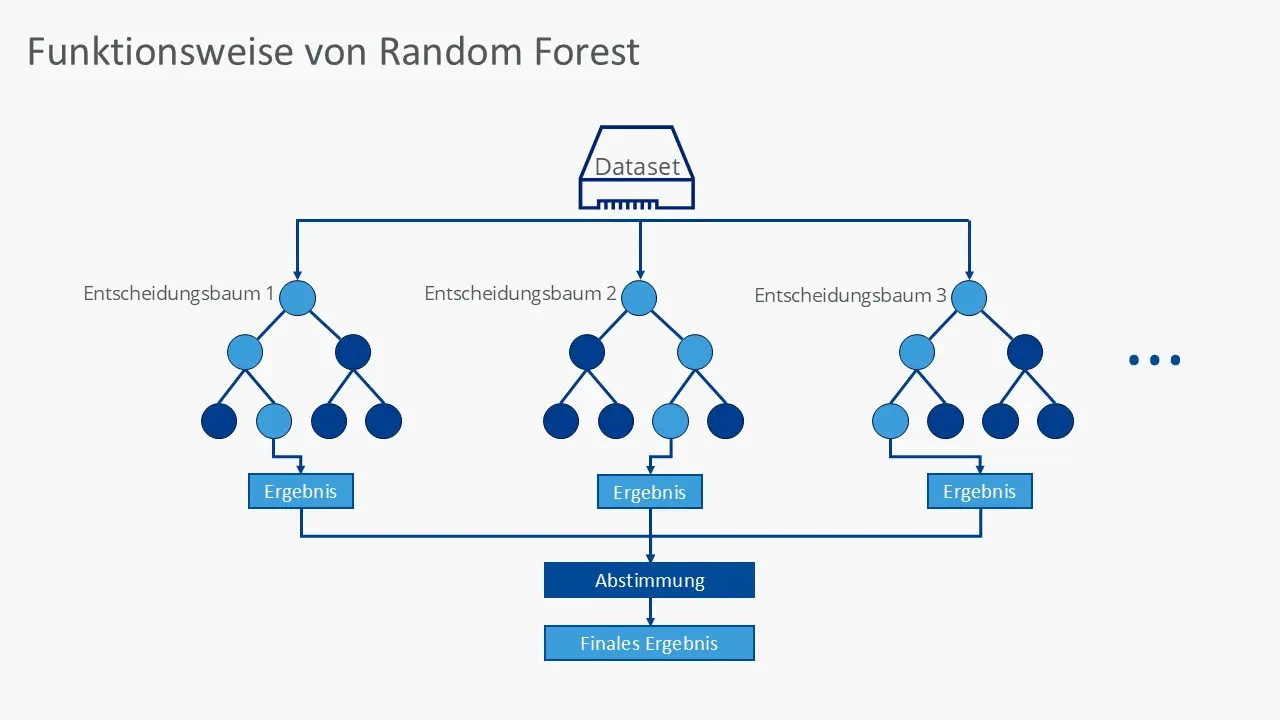

Wie funktioniert Random Forest?

Der Random-Forest-Algorithmus beginnt damit, mehrere zufällige Stichproben aus dem ursprünglichen Datensatz zu erzeugen. Dieser Prozess wird als Bootstrapping bezeichnet. Für jede dieser Stichproben wird in einem zweiten Schritt ein eigener Entscheidungsbaum trainiert. Wichtig ist dabei, dass jeder Baum nur einen zufälligen Teil der verfügbaren Merkmale betrachtet, was die Modelle voneinander unterscheidet. Während des Trainings wird jeder Baum gänzlich unabhängig von den anderen erstellt, sodass sich kleine Unterschiede in den Daten stark auf die Struktur des Baumes auswirken. Bei Klassifikationsproblemen gibt jeder Baum eine Klassenentscheidung ab, bei Regressionsproblemen einen numerischen Wert.

Nach dem Training werden die Ergebnisse aller Bäume kombiniert: Bei Klassifikation entscheidet die Mehrheit der Stimmen, bei Regression wird der Durchschnitt berechnet. Durch dieses Abstimmen wird die Wahrscheinlichkeit reduziert, dass einzelne Ausreißer die Gesamtvorhersage beeinflussen. Random Forest minimiert auf diese Weise Overfitting, da sich falsche Entscheidungen eines Baumes im Durchschnitt ausgleichen. Zusätzlich misst der Algorithmus, wie stark jedes Merkmal zur Vorhersage beiträgt, was bei der Modellinterpretation hilft.

Vorteile und Nachteile eines Random Decision Forests

Random Forest überzeugt durch eine hohe Genauigkeit, Flexibilität und Stabilität, bringt aber wie jeder Algorithmus auch Herausforderungen mit sich.

Vorteile von Random Forest

Random Forest erzielt in der Regel sehr präzise Ergebnisse, selbst wenn Ihre Daten viele Variablen oder starkes Rauschen enthalten. Da der Algorithmus viele Modelle kombiniert, tritt Overfitting deutlich seltener auf als bei einzelnen Entscheidungsbäumen. Zudem kann ein Random Decision Forest gut mit fehlenden Werten umgehen und arbeitet stabil, auch wenn die Datenqualität nicht perfekt ist. Besonders hilfreich ist die Möglichkeit, die Bedeutung einzelner Variablen auszuwerten, was Ihnen hilfreiche Einblicke in die Struktur Ihrer Daten gibt. Darüber hinaus ist der Algorithmus äußerst flexibel und kann sowohl für Klassifikations- als auch für Regressionsaufgaben genutzt werden.

Nachteile von Random Forest

Trotz seiner Vorteile bringt Random Forest einige Herausforderungen mit sich. Wenn sehr viele Bäume im Modell enthalten sind, steigt der Rechenaufwand erheblich, was zu längeren Trainingszeiten führen kann. Auch die Interpretierbarkeit ist eingeschränkt, da ein kompletter Wald aus Entscheidungsbäumen nicht direkt nachvollziehbar ist. Dies macht es in Bereichen, in denen Transparenz wichtig ist, schwieriger, Entscheidungen im Detail zu erklären. Random Forest kann auch bei Echtzeitanforderungen an seine Grenzen stoßen, da die Vorhersage mehrere Bäume durchlaufen muss. In besonders großen Datensätzen kann das Modell außerdem viel Speicherplatz benötigen.

Vor- und Nachteile von Random Forest auf einen Blick

| Vorteile | Nachteile |

|---|---|

| ✓ Hohe Genauigkeit und Robustheit | ✗ Geringere Interpretierbarkeit |

| ✓ Kaum Overfitting | ✗ Hoher Rechenaufwand bei großen Modellen |

| ✓ Funktioniert gut mit vielen Merkmalen | ✗ Langsamere Vorhersagen bei sehr vielen Bäumen |

| ✓ Umgang mit fehlenden Werten | ✗ Speicherintensiv |

| ✗ Weniger geeignet für harte Echtzeitanforderungen |

Was sind typische Use Cases für Random Forest?

Der Random-Forest-Algorithmus wird in vielen Branchen eingesetzt, weil er zuverlässig, robust und vielseitig ist. Besonders vorteilhaft ist der Algorithmus, wenn große Datenmengen, viele Merkmale oder komplexe Muster vorhanden sind.

Kredit- und Risikobewertung

Banken nutzen Random Forest als Teil ihrer KI-Systeme, um die Wahrscheinlichkeit eines Zahlungsausfalls einzuschätzen. Der Algorithmus kann Daten wie Einkommen, Zahlungsverhalten, Beschäftigungsdauer oder Kredithistorie kombinieren. Durch seine Robustheit erkennt er Muster, die Menschen oder selbst einfache neuronale Netze übersehen könnten. Die Vielzahl an Bäumen sorgt dafür, dass zufällige Ausreißer die Entscheidung nicht beeinflussen. Besonders wichtig ist dies für faire und stabile Entscheidungen.

Medizinische Diagnostik

Auch im Gesundheitswesen wird Random Forest häufig als Bestandteil einer KI-gestützten Diagnostik eingesetzt. Er kann Laborwerte, Symptome oder Bildmerkmale kombinieren, um Vorhersagen zu Krankheiten zu treffen. Da medizinische Daten oft unvollständig oder verrauscht sind, profitiert dieses Feld stark von der robusten Natur des Algorithmus. Im Zusammenspiel mit anderen Modellen, etwa einem neuronalen Netz für Bildanalyse, lassen sich zuverlässige Gesamtsysteme bilden.

Betrugserkennung

Unternehmen setzen Random Forest unter anderem in KI-basierten Fraud-Detection-Systemen ein, um betrügerische Transaktionen zu erkennen. Der Algorithmus analysiert Muster in historischen Daten und vergleicht sie mit aktuellen Aktivitäten. Durch seine Fähigkeit, komplexe Zusammenhänge zu erkennen, ist er sehr effektiv bei der Identifikation ungewöhnlicher Verhaltensweisen und performt auch im Vergleich zu einfach aufgebauten neuronalen Netzen sehr gut. Die Fehl-Alarm-Raten bleiben niedrig, da viele Bäume zusammenarbeiten. Selbst wenn einige Bäume fehlerhafte Entscheidungen treffen, gleicht die Mehrheit dies aus. Dadurch erhält das System zuverlässigere Entscheidungen als bei einfachen Methoden.

Random-Forest-Praxisbeispiele

Auch im kleineren Rahmen, aber ebenso in großen Unternehmen, zeigt Random Forest seine Stärke in ganz unterschiedlichen Anwendungsszenarien. Im E-Commerce könnte Random Forest genutzt werden, um vorherzusagen, welche Kundinnen und Kunden wahrscheinlich erneut ein bestimmtes Produkt kaufen. Dazu analysiert das Modell frühere Kaufmuster, Besuchszeiten, Produktkategorien und Interaktionen.

Im Bereich Marketing unterstützen Random-Forest-Modelle Unternehmen dabei, Zielgruppen präziser zu segmentieren. Sie analysieren das Kundenverhalten, demografische Merkmale und Interessen, um personalisierte Kampagnen zu ermöglichen. Dadurch lassen sich Streuverluste reduzieren und Marketingbudgets effizienter einsetzen.

Auch in der Cybersecurity findet das Modell wichtige Anwendung. Der Random-Forest-Algorithmus erkennt ungewöhnliche Netzwerkaktivitäten, indem er Muster aus historischen Daten mit aktuellen Ereignissen vergleicht. Auf diese Weise hilft er dabei, potenzielle Angriffe frühzeitig zu identifizieren und Sicherheitsrisiken zu minimieren.