Was ist KI-Spracherkennung? So funktioniert Sprache zu Text mit KI

KI-basierte Spracherkennung ermöglicht es Computern, menschliche Sprache in Echtzeit zu verstehen und in Text umzuwandeln. Sie ist die Grundlage moderner Sprachassistenten, Diktierfunktionen und automatisierter Kundenkommunikation.

Was bedeutet Spracherkennung mit KI und wie funktioniert Automatic Speech Recognition (ASR)?

KI-Spracherkennung, auch Automatic Speech Recognition (ASR) genannt, wandelt gesprochene Sprache in maschinenlesbaren Text um. Das System analysiert dazu zunächst das Audiosignal und identifiziert dabei akustische Merkmale wie Frequenzen, Tonhöhe und Lautstärke. Anschließend werden diese Merkmale in phonemische Muster übersetzt, also die kleinsten Lauteinheiten der Sprache.

ASR-Systeme nutzen dabei statistische und KI-basierte Modelle, um Wörter und Satzstrukturen vorherzusagen. Typischerweise werden im Vorfeld große Sprachdatenbanken trainiert, damit die Modelle Sprachmuster erkennen und semantische Zusammenhänge ableiten können. Die Systeme lernen auch aus Fehlern: Je mehr Sprachbeispiele verarbeitet werden, desto präziser wird die Erkennung und desto zuverlässiger wandelt die KI Sprache zu Text um. Schließlich wird der erkannte Text in Echtzeit ausgegeben oder für weitere KI-Prozesse aufbereitet. So können beispielsweise Anfragen an Sprachassistenten oder KI-Sprachbots direkt verstanden und beantwortet werden.

Moderne Spracherkennung setzt zunehmend auf End-to-End-Architekturen wie RNN-Transducer (RNN-T) oder Transformer-basierte Modelle. Diese integrieren Akustik- und Sprachinformationen in einem einzigen Lernprozess und ermöglichen effizientere, kontextbewusste Vorhersagen mit geringerer Fehlerquote als klassische Pipeline-Ansätze.

- Persönliche, natürliche Kundeninteraktionen

- Einsatzbereit in wenigen Minuten

- 100 % DSGVO-konform

Technologien hinter der Spracherkennung

KI-Spracherkennung basiert auf einem Zusammenspiel verschiedener Technologien, die gemeinsam Sprache analysieren, interpretieren und in Text umwandeln. Im Folgenden werden die zentralen Bausteine erklärt.

Neuronale Netze

Neuronale Netze bilden das Herzstück heutiger Spracherkennung mit KI. Sie bestehen aus künstlichen Neuronen, die miteinander verbunden sind und lernen, Muster in Audiodaten zu erkennen. Ein neuronales Netz kann beispielsweise wiederkehrende Lautfolgen oder typische Sprachmelodien identifizieren. Durch Training auf großen Mengen an Sprachdaten lernen die Netze, Unterschiede zwischen ähnlichen Lauten wie beispielsweise „b“ und „p“ zu erkennen und Sprache zuverlässig zu segmentieren.

Deep Learning

Der Prozess des Deep Learnings nutzt mehrschichtige neuronale Netze, sogenannte Deep Neural Networks, um komplexe Zusammenhänge in Sprache zu erkennen. Klassische Algorithmen stoßen hier an Grenzen, weil Sprache je nach sprechender Person, Dialekt, Akzent oder Hintergrundgeräuschen hochvariabel ist. Deep Learning ermöglicht es, diese Komplexität zu modellieren, Muster in großen Datenmengen zu erkennen und auch unbekannte Sprachvarianten zu verarbeiten.

Feature-Extraktion

Bevor ein neuronales Netz Sprache analysieren kann, müssen relevante akustische Merkmale aus dem Rohsignal gewonnen werden. Dies geschieht durch die sogenannte Feature-Extraktion. Typische Merkmale sind:

- Formanten: Resonanzfrequenzen, die für die Erkennung von Vokalen entscheidend sind.

- Spektrogramme: Visualisierungen der Frequenzverteilung über die Zeit.

- Mel-Frequency Cepstral Coefficients (MFCCs): Spezielle mathematische Darstellungen, die die wichtigsten Klanginformationen für KI-Modelle zusammenfassen.

Diese Merkmale reduzieren die Datenmenge und heben die sprachrelevanten Informationen hervor, damit die künstliche Intelligenz Spracherkennung effizient durchführen kann.

Sprachmodelle

Große Sprachmodelle wie GPT werden häufig für die ASR-Nachbereitung eingesetzt und verbinden die akustische Analyse dabei mit Kontextwissen. Sie sagen voraus, welche Wörter wahrscheinlich aufeinander folgen und welche Satzstrukturen Sinn ergeben. Dadurch kann das System auch dann die Bedeutung korrekt erfassen, wenn einzelne Wörter undeutlich ausgesprochen werden oder Hintergrundgeräusche vorhanden sind. Sprachmodelle sind entscheidend, um aus der Rohumwandlung von Lauten in Text auch semantisch korrekte Ergebnisse zu erzielen.

Natural Language Processing (NLP)

ASR allein wandelt Sprache in Text um. Die Technologie des Natural Language Processings geht einen Schritt weiter und analysiert die Bedeutung. NLP erkennt Intentionen, Kontext und Satzstrukturen, wertet grammatische Zusammenhänge aus und ermöglicht beispielsweise die Verarbeitung von Befehlen in Sprachassistenten oder die semantische Suche in Transkriptionen. Durch die Kombination von ASR und NLP können KI-Systeme nicht nur Wörter erkennen, sondern verstehen auch die Absicht dahinter.

Welche Faktoren bestimmen die Qualität der KI-Spracherkennung?

Die Genauigkeit von künstlicher Intelligenz in der Spracherkennung hängt von mehreren entscheidenden Faktoren ab. Schon kleine Unterschiede in Aussprache, Lautstärke oder Hintergrundbedingungen können das Ergebnis beeinflussen.

Sprache und Dialekt

Jede Sprache hat ihre eigenen Lautmuster, Grammatikregeln und typischen Wortfolgen. Deshalb benötigen ASR-Systeme in der Regel eigene Modelle für jede Sprache. Dialekte innerhalb einer Sprache stellen für die Spracherkennung mit KI zusätzliche Herausforderungen dar: Wörter werden anders ausgesprochen, Silben können verschluckt oder betont werden und bestimmte Begriffe sind regional unterschiedlich. Ein Beispiel: Der deutsche Satz „Ich gehe zum Bahnhof“ wird in bayerischem Dialekt möglicherweise wie „I geh zum Bafhof“ ausgesprochen und ein Standardmodell könnte dies zunächst falsch erkennen.

Akzente

Akzente verändern die Aussprache einzelner Laute und Silben. Internationale Sprecherinnen und Sprecher können Wörter anders artikulieren, wodurch ein System, das nur auf standardisierte Aussprache trainiert wurde, Schwierigkeiten haben kann. Zum Beispiel sprechen Englischlernende oft „water“ mit einem langen „a“, was ein untrainiertes System falsch transkribieren könnte. Eine hohe Erkennungsgenauigkeit erfordert daher Trainingsdaten, die möglichst viele Akzente abdecken.

Umgebungsgeräusche

Auch Hintergrundgeräusche wie Verkehr, Gespräche im Raum oder mechanische Geräusche verfälschen die akustischen Merkmale der Sprache. Hall oder schlechte Mikrofone können die Signalqualität verschlechtern. ASR-Systeme können diese Störungen teilweise durch Rauschunterdrückung und Filterung kompensieren, aber in besonders lauten Umgebungen steigt die Fehlerquote. So muss eine KI im Call-Center beispielsweise gleichzeitig Stimmen, Tastengeräusche und Klimaanlagenlärm verarbeiten.

Sprachliche Variabilität

Unterschiedliche Lautstärke, Sprechgeschwindigkeit oder Stimmlage beeinflussen die Erkennung. Ein leise sprechender Mensch kann vom System schlechter verstanden werden als jemand mit klarer, normaler Lautstärke. Auch emotionaler Ausdruck wie Aufregung oder Ärger kann die Sprachmelodie verändern und die Transkription erschweren.

Aufnahmequalität

Mikrofontyp, Abtastrate und Kompression wirken sich direkt auf die akustischen Daten aus. Hochwertige Mikrofone liefern klarere Signale, während Telefonleitungen oder einfache Headsets Artefakte erzeugen können, die die Leistung bei der KI-Spracherkennung unter Umständen mindern.

Welche typischen Anwendungsbereiche von Spracherkennung mit KI gibt es?

KI-Spracherkennung ist heute in zahlreichen Anwendungen insbesondere im Business- und Alltagskontext unverzichtbar. Tools wie der KI-Telefonassistent von IONOS zeigen, wie Unternehmen automatisierte Kommunikation effizient einsetzen können.

Diktierfunktionen

Digitale Diktiergeräte oder Apps ermöglichen es, Sprache direkt in Text umzuwandeln. Dies spart Zeit beim Schreiben von Mails, Berichten oder Notizen und sorgt außerdem für mehr Accessibility. Durch präzise Spracherkennung werden Fehler minimiert und komplexe Fachbegriffe werden korrekt erfasst. Viele Systeme unterstützen Echtzeitkorrekturen und Autovervollständigungen. Mit KI lernen diese Systeme individuelle Sprachmuster und verbessern sich kontinuierlich.

Transkription

Transkriptionslösungen wandeln Audio- oder Videodateien automatisch in Text um. Besonders in Konferenzen, Podcasts oder Dokumentationen ist dies wertvoll. ASR analysiert die gesamte Audiospur, segmentiert Sprecher und erstellt durchsuchbare Textversionen. Fortgeschrittene Modelle erkennen auch Füllwörter, Pausen und Satzstrukturen. Unternehmen profitieren von effizienter Dokumentation und besserer Archivierung. KI-basierte Tools sparen zudem manuelle Arbeitszeit.

Sprachassistenten

Sprachassistenten wie Siri, Alexa oder Google Assistant verstehen gesprochene Befehle und antworten direkt. Sie steuern Smart-Home-Geräte, helfen bei der Terminplanung oder liefern Informationen. Die Systeme kombinieren KI-Spracherkennung mit Natural Language Processing, um Bedeutung und Kontext zu erfassen. Hier ist Echtzeit-Spracherkennung besonders wichtig, um flüssige Interaktionen zu ermöglichen.

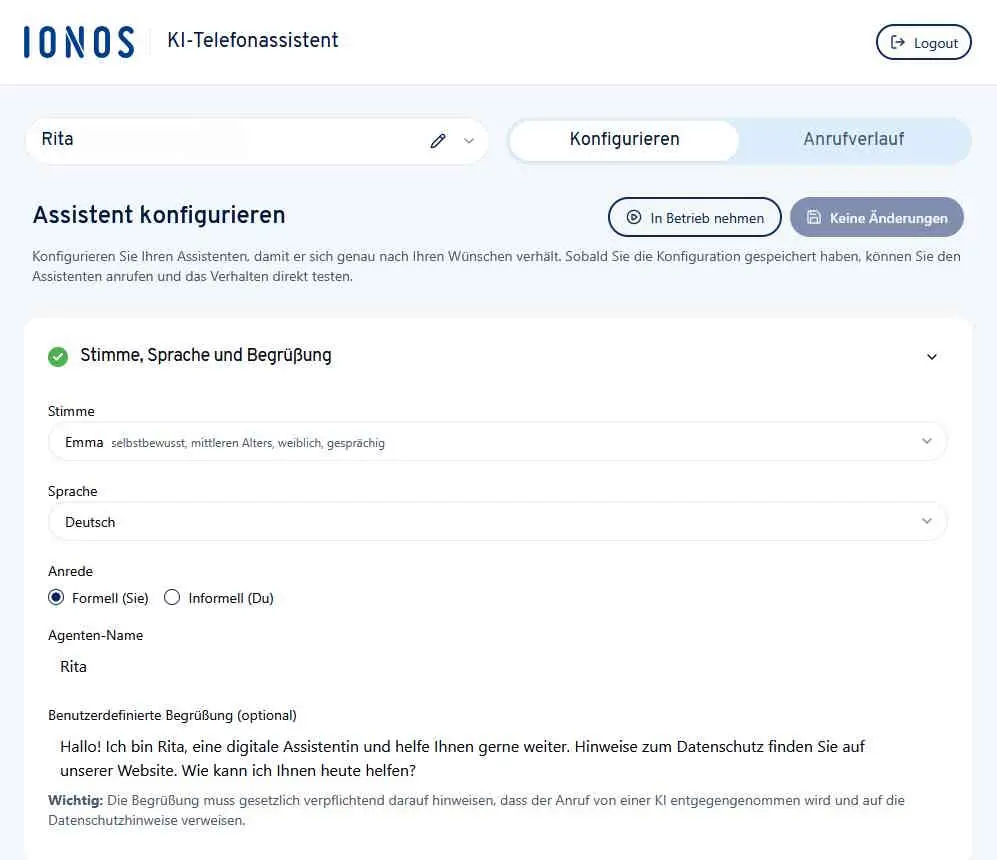

IONOS KI-Telefonassistent

Auch der KI-Telefonassistent von IONOS ist ein praxisnahes Beispiel für Business-Anwendungen: Er erkennt telefonische Kundenanfragen automatisch, transkribiert sie in Echtzeit und antwortet situationsgerecht. So können Unternehmen Warteschleifen reduzieren, Kundenerfahrungen verbessern und Mitarbeiterinnen sowie Mitarbeiter entlasten. Die Integration in bestehende Telefonsysteme macht die Lösung sofort einsatzbereit. Auch individuelle Anpassungen sind möglich. Dieses Tool zeigt, wie KI-Spracherkennung direkt im Geschäftsalltag Mehrwert schafft.

- Persönliche, natürliche Kundeninteraktionen

- Einsatzbereit in wenigen Minuten

- 100 % DSGVO-konform

Führende Tools und APIs

Zu den führenden KI-Spracherkennungslösungen zählen unter anderem die folgenden Lösungen:

- die Google Speech-to-Text-API

- Microsoft Azure Speech

- Amazon Transcribe

- OpenAI Whisper

Sie unterscheiden sich in Sprachabdeckung, Genauigkeit, Echtzeitfähigkeit und Preismodellen. Google punktet mit globaler Sprachauswahl und tief integrierter Cloud. Microsoft legt den Fokus auf Unternehmensintegration und Sicherheitsstandards. Amazon Transcribe bietet skalierbare Streaming-Lösungen für Call-Center. Whisper hingegen überzeugt durch Mehrsprachigkeit und robuste Performance bei Hintergrundgeräuschen. Viele Anbieter stellen APIs bereit, die sich einfach in eigene Anwendungen einbinden lassen. Unternehmen wählen die Lösung im besten Fall nach ihren individuellen Anforderungen an Sprache, Echtzeitfähigkeit und Datenschutz.

Herausforderungen und Grenzen

KI-Spracherkennung ist leistungsfähig, aber nicht fehlerfrei. Homophone, Dialekte oder undeutliche Aussprache können zu Fehlinterpretationen führen. Hintergrundgeräusche und technische Störquellen erschweren die Analyse. Auch Fachbegriffe oder Eigennamen werden nicht immer korrekt erkannt. Um Fehler zu reduzieren, helfen größere, diversifizierte Trainingsdatensätze und kontinuierliches Lernen. Noise-Cancelling-Algorithmen verbessern die Audioqualität. Benutzerdefinierte Sprachmodelle können auf spezifische Branchen oder Unternehmenssprache angepasst werden. Auch Feedbackschleifen, bei denen Korrekturen ins Modell zurückfließen, erhöhen die Präzision. Schließlich ist die Kombination aus ASR und NLP entscheidend, um semantische Missverständnisse zu minimieren.

Datenschutz und DSGVO

Spracherkennung mit KI verarbeitet automatisch sensible personenbezogene Daten, wie Stimme, Gesprächsinhalte oder Kontaktdaten, weshalb Datenschutz essenziell ist. Unternehmen müssen transparent kommunizieren, welche Daten sie erheben, zu welchem Zweck sie verarbeitet werden und wie lange sie gespeichert werden. Die Speicherung von Audio- und Textdaten sollte stets verschlüsselt erfolgen, um unbefugten Zugriff zu verhindern. Wo möglich, sollten Daten darüber hinaus anonymisiert oder pseudonymisiert werden, sodass Rückschlüsse auf einzelne Personen vermieden werden. Nutzerinnen und Nutzer müssen ihre Einwilligung aktiv geben, bevor Sprachaufnahmen verarbeitet werden, und über ihre Rechte auf Auskunft oder Löschung informiert werden. Bei cloudbasierten Diensten ist zusätzlich zu prüfen, wo die Server betrieben werden und welche Sicherheits- und Zertifizierungsstandards eingehalten werden.

Der KI-Telefonassistent von IONOS erfüllt diese Anforderungen, indem alle Kundengespräche DSGVO-konform nur auf EU-Servern gesichert verarbeitet werden. So kombiniert der Telefonassistent automatisierte Sprachverarbeitung mit höchsten Datenschutzstandards, was das Vertrauen von Kundinnen und Kunden stärkt und rechtliche Risiken minimiert.

Seit dem 1. August 2024 gilt in der EU die KI-Verordnung (AI Act), ein gesetzlicher Rahmen zur Regulierung von KI-Systemen mit einem risikobasierten Ansatz. Je nach Risiko, das ein System für Sicherheit oder Grundrechte darstellt, gelten unterschiedliche Pflichten zu Transparenz, Governance und Dokumentation.

- Spezialisierte KI-Assistenten für Content, Design und Code

- Spitzenqualität für professionelle Ergebnisse

- Neueste Technologie mit höchster Sicherheit: in der EU gehostet